1000 nezávislých jadier, 621 miliónov tranzistorov, takt 1,78GHz, nízke napätie a vysoký výpočtový výkon. Taký je prvý 1000-jadrový procesor KiloCore.

Stolné počítače či notebooky majú procesory s viacerými fyzickými jadrami už roky. Tento trend sa postupne rozšíril aj do smartfónov a tabletov a dnes už 10-jadrový procesor v mobile nie je novinkou. Čo však takých 1000 samostatných jadier?

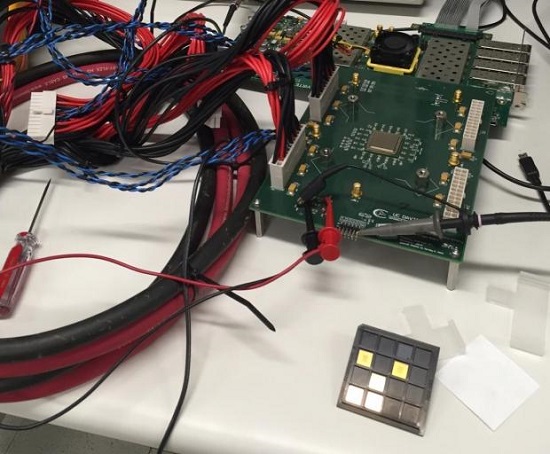

Vedcom z Kalifornskej univerzity v Davise sa podarilo vyrobiť skutočný 1000-jadrový procesor, ktorý nazvali ako KiloCore. Tento procesor má 1000 samostatných, nezávislých jadier, čo znamená, že na rozdiel od grafických kariet, v ktorých je aj viac ako 2000 jadier dokážu jadra KiloCore pracovať samostatne a vykonávať program nezávisle od ostatných jadier.

KiloCore má 621 miliónov tranzistorov a ponúkne výpočtový výkon 1,78 biliónov operácii za sekundu. 1000 jadier procesora pritom nemá až tak nízky takt a pracuje na priemer frekvencii 1,78GHz, pričom maximálny takt je 1,87GHz. Ak je procesor taktovaný nižšie a poskytuje výkon 115 miliónov operácii za sekundu, je jeho spotreba iba 0,7W. Procesor vyrobilo IBM pričom použilo 32nm CMOS proces.

Procesor je tak energeticky efektívny, že tvorcovia tvrdia, že na jeho napájanie stačí AA batéria. Podľa slov vedcov vykonáva KiloCore inštrukcie až 100-násobne efektívnejšie ako moderné procesory v notebookoch.

Momentálne pre takýto 1000-jadrový procesor neexistujú aplikácie, ktoré by vedeli využiť všetky jadrá a ide tak o koncept. Využitie by však raz mohli takéto procesory nájsť v enkódovoaní či dekódovaní videa, šifrovaní a iných oblastiach náročných na procesor.

Zdroj: tweaktown

Pjetro de

MQ

m2fizy

Pjetro de