V nasledujúcej recenzii sa pozrieme na nie celkom obyčajnú GeForce GTX 285 od Gigabyte. GeForce GTX 285 bola ako nástupca GeForce GTX 280 predstavená už v januári, ale len nedávno sa začali na trhu objavovať od výroby mierne pozmenené karty. Medzi takéto môžeme zaradiť aj dnes recenzovanú GV-N285OC-2GI. Je od výroby pretaktovaná, má vlastné PCB a 2GiB VRAM. Keďže sa jedná o „neobyčajnú“ GeForce GTX 285, testovali sme ju aj s neobyčajným vyhladzovaním hrán – 16xS. Ako dopadla karta v našich testoch? Aké má plusy a mínusy? Pokiaľ chcete vedieť odpovede na tieto a ďalšie relevantné otázky, odporúčam

čítať ďalej...Úvod

GeForce GTX 285 uvedená na trh v januári 2009 predstavuje nástupcu GeForce GTX 280 a je založená na 55nm jadre G200B. To predstavuje DIE-shrink 65nm jadra G200. Jedná sa teda o rovnaké jadro, len vyrobené v menšom výrobnom procese. Vďaka tomu sa zmenšila plocha jadra z 576mm^2 na ~480mm^2. Chránené je naďalej HS – heatspreaderom a okolo neho môžeme nájsť ešte kovový rám pre spevnenie PCB. Architektúra jadra a takisto maximálny počet jednotlivých výpočtových jednotiek/clusterov sa pochopiteľne zachoval. Tejto téme som sa venoval v článku:

Súboj performance riešení: Radeon HD 4870 vs. GeForce GTX 260 Takisto som sa venoval v posledných recenziách

Boj o najvyšší výkon: Radeon HD 4870 X2 vs. GeForce GTX 295,

Radeon HD 4890 (CrossFire) vs. GeForce GTX 275 (SLI) téme, prečo bol DIE-shrink „pôvodného“ jadra G200 pre nVidiu taký dôležitý. Na tomto mieste preto len v skratke.

nVidia potrebovala okrem iného znížiť výrobné náklady a mierne zvýšiť výkon high-end karty GeForce GTX 280. Recenzia na PC.sk:

High-end grafické karty: Radeon HD 4850 X2 vs. GeForce GTX 280 (TOP) To docielila „jednou ranou“ DIE-shrinkom. Napriek prvotným vyšším nákladom za menší výrobný proces sa táto skutočnosť po čase vykompenzuje možnosťou vyrobiť viacej jadier na jednom 300mm wafery. Po čase teda klesnú výrobné náklady jedného jadra, ktoré boli v prípade 65nm G200 vysoké. Pri rovnakých pracovných frekvenciách spotrebuje jadro tiež menej energie, lebo môže pracovať s nižším napätím. Túto získanú rezervu v spotrebe je možné zase využiť na vyššie pracovné frekvencie a v konečnom dôsledku aj vyšší výkon.

jadro G200-350-B3 na Gigabyte GTX 285 grafickej karte, klikne pre zväčšenie

jadro G200-350-B3 na Gigabyte GTX 285 grafickej karte, klikne pre zväčšenie

Len vďaka vyšším pracovným frekvenciám má GeForce GTX 285 oproti GeForce GTX 280 vyšší výkon. Frekvencia jadra bola zvýšená o ~8%, shader-core o ~14% a pamäť o 12%. Zo zvýšenia frekvencií je jasné, že GeForce GTX 285 sa presadí voči GeForce GTX 280 výraznejšie v náročnejších nastaveniach a hrách, ktoré potrebujú aritmetický výkon. Tiež vidieť, že nVidia takto dokáže pomerne pružne reagovať na postupne zvyšujúcu sa potrebu aritmetického výkonu.

Celá rezerva v spotrebe, ktorú prinieslo 55nm jadro G200B voči G200 ale nVidia zámerne nevyčerpala. Preto má GeForce GTX 285 nižšie TDP ako GTX 280 a na prevádzku potrebuje len dva 6Pin prídavné konektory. GeForce GTX 280 mala ešte jeden 6Pin a jeden 8Pin. Keby ste do druhého menovaného zapojili len 6Pin, karta by indikovala červenou ledkou, problémy s napájaním. Napájacie obvody sa tiež upravili a už nepôsobia na prvý dojem tak chaoticky, lebo stavebné prvky týchto obvodov sú zoradené v radoch.

Voči GeForce GTX 280 sa tiež prerobilo a zjednodušilo PCB. Veľa spravila skutočnosť, že GeForce GTX 285 má všetkých 16 pamäťových čipov na prednej strane okolo jadra. Nemuseli byť preto vytvorené spojenia s pamäťovými čipmi na zadnej strane ako v prípade GeForce GTX 280, čo ušetrilo štyri vrstvy PCB. PCB GeForce GTX 285 má teda 10 vrstiev, zatiaľ čo PCB GeForce GTX 280 má 14. To je slušná úspora vrstiev, ktoré výrazne ovplyvňujú cenu PCB.

Oproti minulosti tiež nVidia povolila zo zásady, že high-end GeForce karta musí mať referenčné PCB. Viaceré spoločnosti preto používajú upravené PCBs pre svoje GeForce karty. Takisto aj dnes recenzovaná GeForce GTX 285 má takéto „vlastné“ PCB od Gigabyte. Oproti referenčnému má okrem iného zdvojenú medenú vrstvu – 2 oc Copper PCB. Vďaka tomu má mať vylepšené tepelné a vodivé vlastnosti. Zmerať to žiaľ nemôžeme. Nastali aj ďalšie zmeny so súhrnným názvom „Ultra Durable VGA“, ktorým sa ale budem venovať na stránke venovanej grafickej karte.

Pre väčšinu koncových zákazníkov sú však podstatnejšie iné zmeny. Táto karta má oproti referenčnej GTX 285 zdvojnásobenú pamäť VRAM a trochu vyššie pracovné frekvencie. Preto je označená v tabuľkách ako "Gigabyte GeForce GTX 285 2GB OC". Vyššie frekvencie sa pokiaľ nelimituje procesor, určite prejavia vo forme vyššieho výkonu. Bol som ale zvedavý, či sa prejaví v našich testoch aj väčší frame-buffer. nVidia sa rozhodla pre 1GiB VRAM, pretože takáto kapacita by nemala vo väčšine prípadov limitovať výkon GPU, na ktorom je založená GeForce GTX 285. Tá predstavuje momentálne ešte stále celkovo najvýkonnejšiu jednočipovú grafickú kartu na trhu. V prípade tejto skutočnosti nastala zvláštna zhoda medzi nVidiou a AMD/ATi. Aj druhá menovaná ju vidí výkonnostne nad svojou najvýkonnejšou jednočipovou kartou - referenčnou Radeon HD 4890 (

recenzia).

V nasledujúcich testoch som sa preto rozhodol zistiť, či naozaj stačí 1GiB VRAM alebo je 2GiB VRAM zmysluplné navýšenie. Väčšia VRAM prinesie len vtedy úžitok, keď má GPU dostatok výkonu, ale VRAM je už plná a musí byť využívaná oveľa pomalšia systémová pamäť. Pri porovnaní Radeon a GeForce kariet, stráca druhá, ak nemá dostatok VRAM oveľa viacej výkonu. Dôvodom je fakt, že nVidia GPUs dokážu od G80 texturovať len z VRAM a v HW formáte. Čo znamená, že GeForce karty musia, ak nie je dostatok VRAM, najprv kopírovať potrebné údaje do VRAM, iné zmazať a až následne ich môžu použiť. Preto sa môže zdať, že Radeon karty vedia lepšie využiť svoju VRAM a stačí im 1GiB aj na rozlíšenia, kedy 1GiB VRAM na GeForce kartách nestačí. V skutočnosti ale majú zaplnenú zhruba rovnako VRAM (GeForce potrebuje možno trochu viac MB, ak sa uskutočňuje ešte stále „Filter-On-Scanout“) a pre vyššie zmienený nedostatok stráca GeForce zbytočne veľa výkonu.

Nájsť takéto prípady, kedy má GPU dostatok výkonu ale 1GiB VRAM už nestačí, nebude teda ľahké, lebo vo vyšších rozlíšeniach, kedy sa použijú textúry s vyšším rozlíšením, nemusí mať GPU už dostatok výkonu. Práve textúry sú najväčším „žrútom“ pamäte a nie rozlíšenie, ako by si niekto mohol chybne myslieť. Aj z tohto dôvodu som testoval v rozlíšeniach 1920x1200 a 2560x1600 s 8xMSAA a 16xAF. 8xMSAA síce stojí pre

horší frame-buffer formát na GeForce GPUs viacej výkonu ako na Radeon kartách, ale spotrebuje voči 4xMSAA viacej pamäte VRAM.

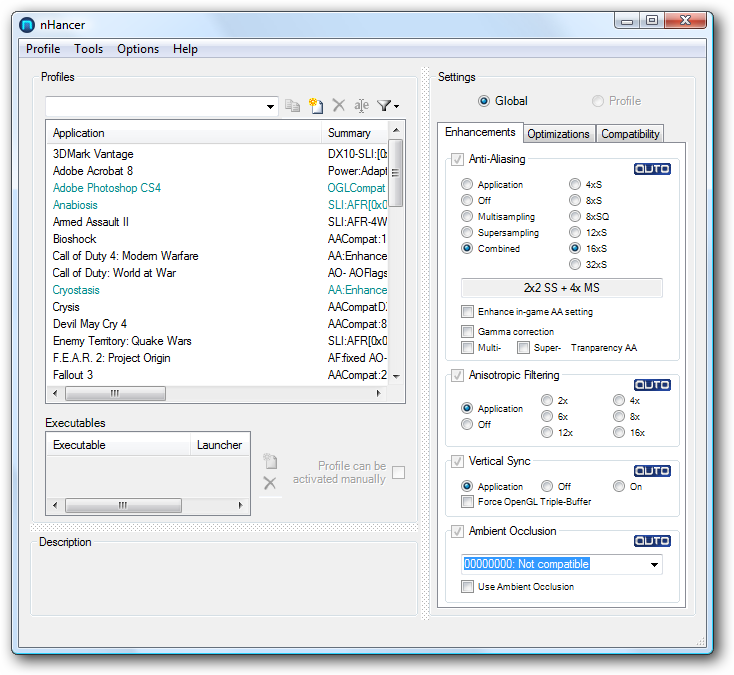

Z toho istého dôvodu som sa rozhodol spraviť aj porovnanie s menej používaným vyhladzovaním -16xS. Pred vydaním GeForce 8000 série ho bolo ešte možné nájsť v ovládacom panely ovládačov. S vydaním GeForce 8800GTX ale zmizol tento kombinovaný mód a bol nahradení CSAA módmi. Napriek tomu, že nVidia tento krok nekomentovala, bol dôvod jasný. Jedná sa o „brute force“ metódu, ktorá potrebuje príliš veľa výkonu a bola v podstate dostupná už v časoch 3Dfx. Preto na tomto mieste znovu pripomeniem, čo je 16xS za vyhladzovanie hrán. Jedná sa o tzv. kombinovaný mód, ktorý je možné zapnúť pomocou

aplikácie nHancer len na GeForce kartách. GeForce GTX 200 karty teda na rozdiel od Radeon HD 4000 kariet naďalej neoficiálne podporujú čistý Ordered Grid SupeSampling a kombinované módy. Kombinovaný mód preto, lebo sa jedná o kombináciu SuperSampling a MultiSampling Anti-aliasingu. Presnejšie 2x2 OG-SSAA a 4xMSAA v prípade „16xS“. Najprv sa teda obraz renderuje s dva krát väčším rozlíšení (väčší rendertarget) v oboch smeroch ako máte nastavené a následne sa „downsamplingom“ zmenší na finálne rozlíšenie. Vďaka tomu sa vyhladí celá scéna a nielen hrany polygonov, ale aj textúry, shadery, tiene atď. V poslednej fáze sa aplikuje ešte 4xMSAA, teda štvornásobný MultiSampling, najčastejšie používané vyhladzovanie hrán.

Pokiaľ teda všetko funguje ako má, je výsledok po stránke kvality, naozaj výborný. Žiaľ takéto vyhladenie stojí veľa výkonu pre spôsob ako je uskutočnené. Záťaž na GPU je rovnaká, ako keby muselo renderovať obraz v tom 2x väčšom rozlíšení v oboch smeroch a ešte aplikovať 4xMSAA. Pre lepšie predstavenie uvediem príklad. Ak máte natívne rozlíšenie 1920x1200, tak musí GPU renderovať obraz so 16xS v rozlíšení 3840x2400, downsamplovať ho na 1920x1200 a pridať ešte 4xMSAA. Okrem výkonu potrebuje 16xS logicky aj väčšiu pamäť VRAM. To je dôvod prečo som zaradil testy so 16xS do tejto recenzii. Ďalšia nevýhoda 16xS je, že funguje len v Direct3D 9 a v určitých hrách spôsobuje rozmazanie textúr. Z testovaných je to len Call of Duty: World at War. Dôvod je znovu v princípe, ako je uskutočnené 16xS. Aplikácia jednoducho nevie o zväčšenom rendertargete, čo spôsobuje problémy s rôznymi post-processing efektami.

Grafickú kartu a ďalšie detaily som objasnil, poďme sa preto pozrieť na jej teoretické technické parametre a následne výkon. Vďaka spoločnosti

Gigabyte sme mohli uskutočniť testy na novej „Nehalem“ testovacej zostave s Gigabyte

X58-Extreme základnou doskou, ktorá umožňuje SLI a CF. O napájanie sa staral

800W ODIN zdroj. Testy prebehli vďaka spoločnosti

Samsung aj v rozlíšení 2560x1600, ktorá nám vypožičala na test 30“ LCD

SyncMaster 305T+ (

recenzia na PC.sk).

Timmy2k

nManJofo

crux2005